در این مقاله میخواهیم به معرفی جدیدترین هوش مصنوعی کمپانی Meta یعنی هوش مصنوعی Llama 3 بپردازیم. متا (Meta)، که قبلاً با نام فیسبوک شناخته میشد، یک شرکت فناوری چند ملیتی آمریکایی است که مقر آن در منلو پارک، کالیفرنیا است. این شرکت مالک تعدادی از محبوبترین پلتفرمهای رسانههای اجتماعی در جهان، از جمله فیسبوک، اینستاگرام، واتساپ و مسنجر است.

متا، مدل زبان منبع باز نسل بعدی خود به نام Llama 3 را معرفی کرده است که عملکرد جدیدی را در زمینه استدلال، تولید کد و دنبال کردن دستورالعملها ارائه میدهد. این شرکت Llama 3 را به عنوان «قادرترین مدل زبان بزرگ در دسترس عموم» تا به امروز معرفی میکند و از رقبایی مانند گوگل و Anthropic در مقیاسهای مشابه پیشی میگیرد.

سری Llama مدلهای زبان بزرگ، یکی از مهمترین موارد در حوزه هوش مصنوعی است که بسیاری از برنامهها را راهاندازی میکند و اساس مدلهایی را تشکیل میدهد که توسعهدهندگان بر اساس آنها مدلهایی مانند Vicuna و Alpaca را ساختهاند.

تاریخچه کمپانی متا

متا در سال 2004 توسط مارک زاکربرگ، ادواردو ساورین، داستین موسکوویتز و کریس هیوز تأسیس شد و از آن زمان به یکی از ارزشمندترین شرکتهای جهان تبدیل شده است. این شرکت به دلیل تأثیر قابل توجهی که بر نحوه ارتباط و اشتراکگذاری اطلاعات افراد دارد، مورد انتقاد و بحثهای زیادی قرار گرفته است.

در اکتبر 2021، فیسبوک نام خود را به متا تغییر داد تا تمرکز خود را بر روی توسعه متاورس، یک فضای مجازی مشترک که در آن مردم میتوانند با یکدیگر تعامل داشته باشند، کار کنند و بازی کنند، نشان دهد. این تغییر نام با واکنشهای متفاوتی روبرو شد و برخی آن را تلاشی برای انحراف توجه از رسواییها و چالشهای متعدد شرکت میدانستند.

معرفی هوش مصنوعی Llama 3

در این قسمت به معرفی هوش مصنوعی کمپانی Meta از زبان توسعهدهندگان خود این کمپانی میپردازیم.

“امروز، ما بسیار هیجانزدهایم که از در دسترس قرار گرفتن دو مدل اول از نسل بعدی Llama، یعنی متا Llama 3، برای استفاده گسترده خبر دهیم. این انتشار شامل مدلهای زبانی از پیش آموزشدیده و با دستورالعملهای ظریف تنظیمشده با حداقل 8 میلیارد و حداکثر 70 میلیارد پارامتر است که میتواند از طیف وسیعی از موارد استفاده پشتیبانی کند. این نسل بعدی Llama عملکردی در سطح فناوری را بر روی طیف وسیعی از معیارهای صنعتی نشان میدهد و قابلیتهای جدیدی از جمله استدلال بهبودیافته را ارائه میدهد. ما معتقدیم که اینها بهترین مدلهای متنباز در کلاس خود هستند، همینطور هم هست. برای حمایت از رویکرد باز دیرینهمان، Llama 3 را در اختیار جامعه قرار میدهیم. ما میخواهیم موج بعدی نوآوری در هوش مصنوعی را در سراسر مجموعه راهاندازی کنیم، از برنامههای کاربردی گرفته تا ابزارهای توسعهدهنده و ارزیابیها تا بهینهسازیهای استنتاج و موارد دیگر. ما مشتاقانه منتظر دیدن چیزی هستیم که شما میسازید و از بازخورد شما استقبال میکنیم.”

بهبودهای هوش مصنوعی Llama 3 نسبت به نسل قبل

طبق اعلام متا، این نسل بعدی از هوش مصنوعی Llama عملکردی در سطح فناوری را بر روی طیف وسیعی از معیارهای صنعتی نشان میدهد و قابلیتهای جدیدی از جمله استدلال بهبودیافته را ارائه میدهد.

مدلهای جدید، ظرافتهای زبان را درک کرده و میتوانند کارهای پیچیدهای مانند ترجمه و تولید گفتوگو را انجام دهند.

متا مقیاسپذیری و عملکرد مدل را افزایش داده است تا Llama 3 بتواند وظایف چند مرحلهای را مدیریت کند. شرکت مادر فیسبوک ادعا میکند که این مدل، قابلیتهایی مانند استدلال، تولید کد و دنبال کردن دستورالعملها را «بهطور چشمگیری ارتقا میدهد».

همچنین، Llama 3 نسبت به نسخههای قبلی نرخ رد درخواست کمتری دارد زیرا مهندسان هوش مصنوعی متا فرآیند پس از آموزش اصلاحشدهتری را اتخاذ کردهاند که باعث افزایش تنوع پاسخهای مدل نیز شده است.

Llama 3 در دو اندازه عرضه میشود – هشت میلیارد پارامتر، که کمی بزرگتر از کوچکترین مدل Llama قبلی است، و یک نسخه 70 میلیارد پارامتری.

هر دو نسخه دارای طول زمینه 8k هستند، به این معنی که میتوانند ورودیهایی با حدود 6000 کلمه محتوا را مدیریت کنند.

کسب و کارها میتوانند از امروز با Llama 3 کار کنند. این مدل برای دانلود از وب سایت متا در دسترس است. همچنین در سرویسهای ابری از جمله AWS از طریق Amazon SageMaker JumpStart قابل دسترسی است.

مدلهای Llama 3 در Databricks، Google Cloud، Hugging Face، IBM WatsonX ،Nvidia Nim و Microsoft Azure و همچنین بسیاری دیگر از سایتهای معتبر در دسترس قرار خواهند گرفت..

این مدل از سخت افزارهای طیف وسیعی از تامینکنندگان از جمله AMD ،AWS، Dell، Intel، Nvidia و Qualcomm پشتیبانی میکند.

ویژگیها و قابلیتهای هوش مصنوعی کمپانی متا

Llama 3 با قابلیت استفاده بسیار بالا برای بسیاری از توسعهدهندگان در سراسر جهان، و با یکپارچهسازی با پلتفرمهای مختلف، به کاربران این امکان را میدهد تا از آن در سناریوهای مختلف استفاده کنند.

در اینجا به چند ویژگی و قابلیت هوش مصنوعی Llama 3 که توسعهدهندگان مختلف امتحان کرده و نتیجه را اطلاع دادهاند، میپردازیم.

1. ایجاد یک برنامه واکنشپذیر (React Application)

آشوتوش سریواستوا، علاقهمند به هوش مصنوعی، سعی کرد از Llama 3 برای کدنویسی در Perplexity Labs استفاده کند. او از مدل هوش مصنوعی خواست تا یک برنامه تکصفحهای واکنشپذیر (React Application) به نام «مدیریت وظیفه» (Task Manager) توسعه دهد. او همچنین به مدل دستور داد تا این برنامه با یک رابط کاربری با طراحی خوب و با چندین قابلیت همراه باشد.

Llama 3 درخشان ظاهر شد!

Llama 3 در ایجاد کدهای منبع برای فایل app.jsx، فایل اصلی در برنامه React، کار فوقالعادهای انجام داد. نکته جالب دیگر این است که کاربر از مدل هوش مصنوعی خواسته است تا استقرار React را در Netlify انجام دهد، که Llama 3 با موفقیت یک کد json برای استقرار Netlify ایجاد کرد.

کاربر همچنین یک رابط استایلدهی Tailwind CSS را میخواست که Llama 3 آن را نیز تضمین کرد. در نهایت، یک فایل README نیز ارائه کرد که حاوی تمام جزئیات مربوط به استقرار برنامه React است.

در انتهای ویدیو، میبینیم که کاربر با موفقیت تمام کدهای نوشته شده توسط هوش مصنوعی متا را اجرا میکند و برنامه Task Manager React با موفقیت اجرا میشود. بنابراین Llama 3 یک مدل هوش مصنوعی عالی برای کارهای مرتبط با کدگذاری است.

2. بررسی سرعت Llama 3

هارشا، علاقهمند به هوش مصنوعی، Llama 3 را مورد بررسی سرعت قرار داد. او یک دستور ساده به Llama 3 داد و زمان پاسخ را ثبت کرد. نتایج عالی بود زیرا سرعت دریافت توکن (Prompt Token Rate) 66.378 توکن بر ثانیه و سرعت پاسخگویی توکن (Response Token Rate) 19.596 توکن بر ثانیه بود. کاربر این تست را روی Llama در پلتفرم MLX انجام داد.

میتوانیم در ویدیوی بالا زمانهای پاسخدهی و همچنین کارآمدی Llama 3 در تولید پاسخ را ببینیم. لاما از نظر زمان پاسخگویی سریع به درجات بالایی میرسد.

3. جستجو در اینترنت

ناظم، علاقهمند به هوش مصنوعی، از Llama 3 در Page Assist برای جستجو در اینترنت استفاده کرد. کاربر از مدل LLM در مورد زمان پخش قسمت بعدی سریال شلدون پرسید.

Llama در جستجو در اینترنت و ارائه اطلاعات دقیق به کاربر در مورد زمان پخش قسمت بعدی شلدون، کار فوقالعادهای انجام داد. این مدل هوش مصنوعی همچنین لینکهایی را ارائه کرد که کاربر میتوانست از طریق آنها قسمت بعدی را تماشا کند.

این قابلیت [Llama 3 برای جستجوی زنده در اینترنت] یک ویژگی بسیار پیشگامانه است، زیرا بسیاری از مدلهای LLM تاکنون قادر به استخراج اطلاعات زنده از طریق جستجو در اینترنت نبودهاند و Llama 3 شرکت Meta دقیقا برای انجام همین کار ساخته شده است.

4. تولید تصویر

هوش مصنوعی متا که از Llama 3 LLM استفاده میکند نیز میتواند تصاویر تولید کند. همچنین میتوانید تصاویر موجود خود را متحرک کنید. در اینجا یک ویدیو از یک کاربر گرفته شده است که در آن میتوانید ببینید که او یک انیمیشن تصویری از یک موجود بیگانه در حال بازی در زیر آب ایجاد کرده است. این شگفت انگیز است.

امروزه تولید تصویر بسیار کارآمد برای ثبت تمام نیازها و ویژگیها چیزی است که توسعهدهندگان به آن نیاز دارند.

5. ارتقای پلتفرم Maestro

Llama 3 اکنون میتواند برای دستیابی کامل به حداکثر پتانسیل چندین پلتفرم مورد استفاده قرار گیرد. یکی از این پلتفرمها، پلتفرم Maestro است.

کاربری به نام پیترو اسکیرانو، بنیانگذار EverArt AI، سعی کرد از Llama 3 برای تقویت پلتفرم Maestro استفاده کند. او از پلتفرم Maestro مبتنی بر Llama 3 خواست تا یک اسکریپت پایتون برای یک فریمورک بازی تولید کند، و این ابزار به طور شگفتانگیزی این کار را انجام داد.

این کاربر حتی بیان کرد که این مدل برای اجرای چنین عملیاتی به صورت محلی، از Claude 3 Sonnet عملکرد بهتری دارد، بنابراین این واقعاً یک ویژگی مفید برای جامعه توسعهدهندگان است.

توجه داشته باشید که رابط کاربری در Maestro کمی با رابط کاربری Llama متفاوت است و شما باید در درخواستهای خود جزئیات بیشتری را ذکر کنید.

6. ساخت گیف و ویدیو

Llama 3 حتی قادر به ساختن GIF و ویدیو است. در زیر نمونهای از یک گیف متحرک که با استفاده از هوش مصنوعی متا ساخته شده است را مشاهده میکنید.

یک تابع برای تولید GIF و ویدیو در Llama 3 برای استفاده همه وجود دارد.

7. ایجاد یک برنامه Tic-Tac-Toe

سنان، یک علاقهمند و توسعهدهنده هوش مصنوعی، مدل Llama 3 را آزمایش کرد. او از مدل 70 میلیارد پارامتر دستورالعملدهی Llama 3 استفاده کرد و از آن خواست یک برنامه سادهی بازی ضربدر-مدار (تیک-تاک-تو) با جاوااسکریپت ساده بسازد. هوش مصنوعی متا بار دیگر با ارائه کدهای HTML، CSS و JS تحت تأثیر قرار داد و یک برنامهی ضربدر-مدار کاملاً کاربردی برای اجرای این کدها ساخته شد.

این نشان میدهد که Llama 3 دارای تواناییهای کدنویسی بسیار کارآمدی است و میتوانید از آن برای توسعه برنامهها یا حتی میزبانی وبسایتها هم FrontEnd و هم BackEnd استفاده کنید.

8. استفاده از رابطهای Gradio برای برنامهها

علاوه بر ایجاد تصاویر، گیفها و ویدیوها، چه کسی فکر میکرد که Llama 3 میتواند برای ساخت کل یک برنامهی تولیدکنندهی تصویر استفاده شود؟ در اینجا ویدیویی توسط کاربری به اشتراک گذاشته شده است که او از هوش مصنوعی متا درخواست کرد تا «یک برنامهی Gradio مینیمال که بتواند با استفاده از کتابخانهی Diffusers، یک تصویر با استفاده از Stable Diffusion XL Turbo تولید کند» بسازد.

Llama در ایجاد کد برای برنامهی Gradio با تمام بخشها و قابلیتهای مورد نیاز، به طرز شگفتانگیزی خوب عمل کرد. اگرچه کاربر کد را اجرا نکرد، اما کد بسیار کارآمد به نظر میرسد و ممکن است بتواند برنامهی تولیدکنندهی تصویر را به درستی مستقر کند. این کد حاوی ماژولهای مورد نیاز مانند gradio و torch است که برای اجرای برنامه لازم است.

همین کاربر تصمیم گرفت مدل را دوباره آزمایش کند. این بار او از Llama 3، هوش مصنوعی متا، خواست تا یک کد پایتون بنویسد که بتواند یک فایل ویدیویی را به عنوان ورودی بگیرد و فریمهای ویدیو را معکوس کند. در اینجا نیز او یک رابط Gradio درخواست کرد. Llama با نوشتن اسکریپت پایتون با تمام ماژولها و الزامات، باز هم به طرز شگفتانگیزی عمل کرد. کاربر به صورت محلی با Open-WebUI به Llama 3 دسترسی پیدا کرد.

درست است! این بخش به ما نشان میدهد که هوش مصنوعی متا میتواند به خوبی با یکپارچهسازی چندین ماژول و ایجاد کدها و برنامههای کاربردی کارآمد عمل کند. این ویژگیای است که توسعهدهندگان آن را دوست خواهند داشت.

9. RAG محلی

شما میتوانید از Retrieval Augmented Generation کاملاً محلی با مدل Llama 3 در پلتفرم Ollama استفاده کنید. در اینجا یک ویدیو از یک کاربر است که در آن، او از Llama 3 به صورت محلی از طریق Ollama استفاده کرده است. شما میتوانید ویژگی RAG را در عمل مشاهده کنید، زیرا او چندین سؤال در زمان واقعی درباره خود Llama 3 میپرسد. مدل در استخراج این اطلاعات و پاسخ به سوالات به خوبی عمل میکند.

چندین مدل زبان بزرگ (LLM) وجود دارند که به صورت محلی از بازیابی تقویتشده با تولید (RAG) استفاده میکنند و خوشحالیم که شاهد هستیم Llama 3 متا یکی از این LLMها است.

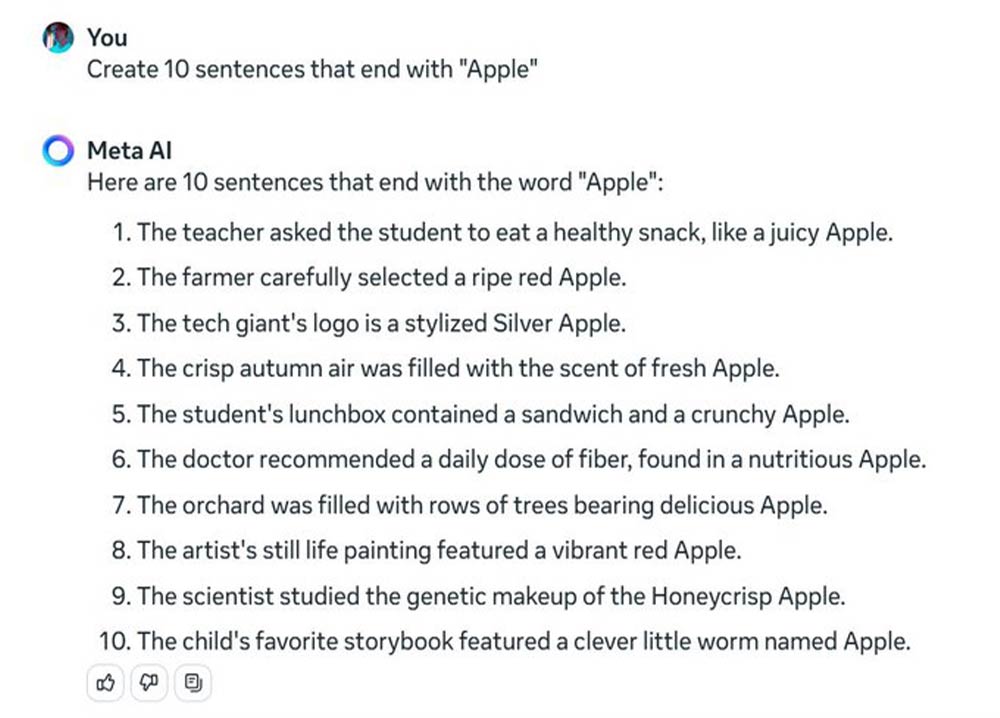

10. آزمون سیب (Apple Test)

یک کاربر به نام ویتور دِ لوکا، Llama 3 را با «آزمون سیب» مورد آزمایش قرار داد. این آزمون به این صورت است که باید ده جمله ساخته شود که با کلمه «سیب» تمام شوند. هوش مصنوعی متا در انجام این کار با موفقیت خارقالعادهای عمل کرد و ده جملهی منحصر به فرد که با کلمه «سیب» تمام میشدند را ارائه داد.

تعداد زیادی از LLMها در این آزمون موفق نبودهاند. این کاربر حتی اظهار داشت که Claude 3 Opus نیز نتوانسته این تست را به درستی اجرا کند. اما در اینجا ما Llama 3 متا را داریم که شگفتانگیز است. این به ما ایده میدهد که هوش مصنوعی Llama 3 چقدر در ایجاد پاسخهایی که نیاز به تفکر عمیق همراه با پردازش زبان طبیعی دارد، قدرتمند و کارآمد است.

آینده هوش مصنوعی کمپانی Meta

متا از راهاندازی دو مدل Llama 3 خبر داد، اما گفت که این «فقط آغاز» است.

پیش از این، متا در زمان راهاندازی Llama 2 نسخهای با ۱۳ میلیارد پارامتر عرضه کرده بود و این شرکت قصد دارد نسخههای بزرگتر و همچنین نسخههای طولانیتر با حافظه و طول زمینه بهبود یافته مانند Llama 2 Long را راهاندازی کند.

توسعهدهنده Llama نگاهی اجمالی به یک مدل آینده انداخت، نسخهای از Llama 3 که حجمی معادل باورنکردنی 400 میلیارد پارامتر دارد. این احتمالا باعث میشود تا این مدل، بزرگترین مدل متنباز منتشر شده تا به امروز باشد.

در حالی که متا هنوز در حال آموزش این سیستمها است، جزئیاتی اولیه از عملکرد مدل را به نمایش گذاشت که در آن، یک نسخه اولیه از مدل 400 میلیارد پارامتری، امتیازات قابل توجهی را در معیارهای استاندارد صنعتی به دست آورد.

این شرکت اعلام کرد: “تیم ما از روند پیشرفت این مدلها هیجانزده است”.

جیم فن، پژوهشگر ارشد هوش مصنوعی در Nvidia Research، در واکنش به این راهاندازی گفت که نسخه 400 میلیارد پارامتری، زمانی که راهاندازی شود، “نقطه عطفی را رقم خواهد زد که جامعه به صورت رایگان به مدلی در کلاس GPT-4 دسترسی پیدا خواهد کرد.”

فن در X (که قبلا توییتر نام داشت) گفت: “[مدل 400 میلیارد پارامتری] محاسبات را برای بسیاری از تلاشهای تحقیقاتی و استارتآپهای نوپا تغییر خواهد داد”.

ساختار و عملکرد هوش مصنوعی Llama 3

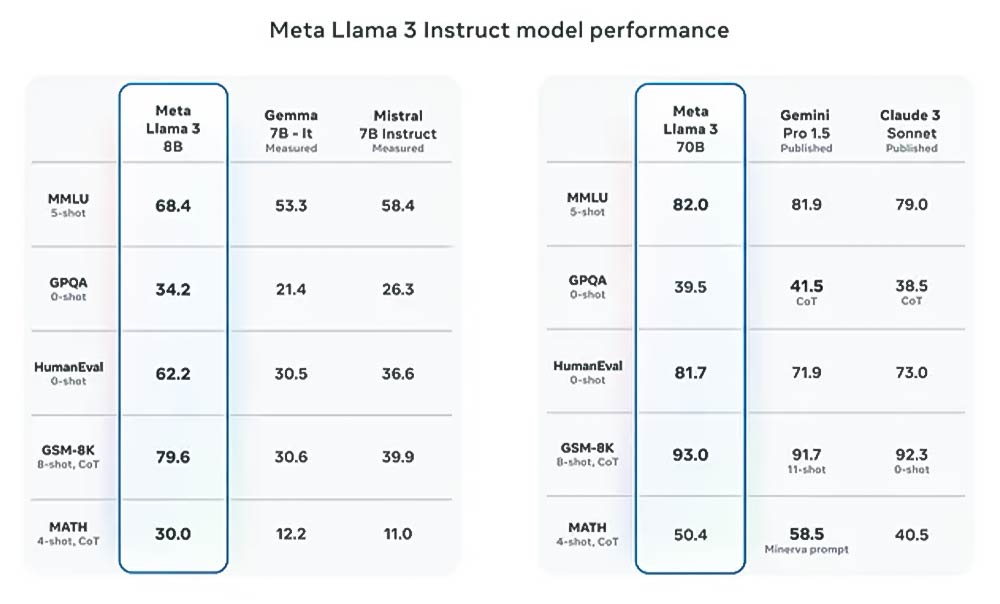

مدلهای بزرگ زبانِ جدید بسیار قدرتمند هستند و در معیارهای صنعتی مانند MMLU و HumanEval به عملکردی در سطحِ پیشرفته دست یافتهاند. این مدلها شامل مدلهای از پیش آموزشدیده و مدلهایی با تنظیم دقیق بر اساس دستورالعمل هستند که عملکردی در سطحِ پیشرفته را در معیارهای صنعتی نشان میدهند و همچنین در مقایسه با نسخههای قبلی، از قابلیت استدلال و کدگذاری بهبود یافتهای برخوردارند.

مدل کوچکتر Llama 3 به امتیازهای بسیار بالاتری نسبت به مدلهای Gemma-7B گوگل و Mistral-7B Instruct شرکت Mistal دست یافته است.

در همین حال، مدل بزرگتر Llama 3 از امتیازهای هر دو مدل Gemini Pro 1.5 گوگل و Claude 3 Sonnet شرکت Anthropic پیشی گرفته است. با این حال، هر دو مدل سیستمهای مبتنی بر کد بسته هستند، به این معنی که Meta مجبور بود بر اساس امتیازهایی که توسعهدهندگان مدلهای مربوطه منتشر کردهاند، عمل کند.

یان لوکون، دانشمند ارشد هوش مصنوعی Meta، در X (که قبلاً با نام توییتر شناخته میشد) گفت که تیم پشت LLama 3 حتی نتایجی را مشاهده کردهاند که در آن مدل کوچکتر از نسخه بزرگتر در برخی از وظایف عملکرد بهتری داشته است.

دلیل عملکرد خوب این مدلها معماری پایهای آنها است که با بهبود رویههای پس از آموزش متا، «نرخ رد کاذب را به میزان قابل توجهی کاهش داده، همراستاسازی را بهبود بخشیده و تنوع پاسخهای مدل را افزایش داده است».

به عبارت ساده، معماری پایهای به هوش مصنوعی متا این امکان را میدهد که در مقایسه با تکرارهای قبلی، در تولید متن بهتر عمل کند.

با افزودن توجه پرس و جوی گروهی (GQA) به این ترکیب، کارایی مدل نیز بهبود یافته است.

برای پشتیبانی از استقرار مسئولانه، متا ابزارهای جدیدی مانند Llama Guard 2 برای فیلتر کردن محتوا بر اساس طبقهبندی MLCommons، CyberSec Eval 2 برای ارزیابی خطرات مرتبط با تولید کد و Code Shield برای فیلتر کردن خروجی کدهای ناامن در زمان اجرا معرفی کرد.

جزئیات آموزش Llama 3

اگرچه متا جزئیات مجموعه دادهای که برای آموزش Llama 3 استفاده کرده است را فاش نکرده است، اما این شرکت فاش کرد که این مدل با استفاده از یک «مجموعه داده آموزشی بزرگ و باکیفیت» ساخته شده است که هفت برابر بزرگتر از مجموعه دادهای است که برای Llama 2 استفاده شده است و چهار برابر مقدار کد بیشتری دارد.

متا اعلام کرد که بر روی دادههای از پیش آموزش داده شده، یعنی دادههایی که برای آموزش اولیه یک مدل استفاده میشوند، با استفاده از بیش از 15 تریلیون توکن از منابع موجود به صورت عمومی، تأکید زیادی کرده است.

بیش از 5 درصد از این مجموعه داده، دادههای غیرانگلیسی باکیفیت از بیش از 30 زبان است، اگرچه متا انتظار ندارد که سطح عملکرد در این زبانها به اندازه زبان انگلیسی باشد.

Llama 3 همچنین از مجموعهای از خطوط لوله فیلتر داده برای پاکسازی دادههای از پیش آموزش داده شده، استفاده میکند. برخی از این خطوط لوله برای محتوای نامناسب (NSFW) و طبقهبندیکنندههای متن برای پیشبینی کیفیت داده فیلتر میشوند.

مجموعه داده Llama 3 همچنین حاوی دادههای مصنوعی است. متا از مدل Llama 2 قبلی برای تولید دادههای آموزشی برای طبقهبندیکنندههای کیفیت متن استفاده کرد.

این مدل روی دو خوشه GPU سفارشی در مقیاس مرکز داده آموزش داده شد که هر کدام حاوی 24576 پردازنده گرافیکی Nvidia H100 هستند. متا زیرساخت مورد استفاده برای آموزش این مدل را در ماه مارس فاش کرد. همچنین از این مجموعه سختافزاری عظیم برای تحقیق و توسعه گستردهتر هوش مصنوعی استفاده میکند.

با وجود عدم افشای دادههای آموزشی که در هوش مصنوعی متا استفاده شده است، متا تعهد خود را نسبت به توسعه متنباز تأیید کرد.

این شرکت گفت: «ما مدتهاست بر این باوریم که گشودگی منجر به محصولات بهتر، امنتر، نوآوری سریعتر و یک بازار کلی سالمتر میشود. این برای متا و برای جامعه مفید است». «ما با Llama 3 رویکردی مبتنی بر جامعه را در پیش میگیریم و از امروز، این مدلها روی سرویسهای ابری پیشرو، هاستینگ و پلتفرمهای سختافزاری با تعداد بسیار بیشتری در دسترس هستند.»

Llama 3 یک پیشرفت عظیم از سوی متا به دنیای هوش مصنوعی مولد است. این مدل LLM به شدت قدرتمند است، زیرا زمان پاسخگویی سریع به درخواستها، تولید تصاویر با کیفیت بالا، ایجاد و اسکریپتنویسی کدها و برنامههای کاربردی کارآمد، خدمات قدرتمند فعالشده به صورت محلی و همچنین گذراندن چندین تست را به نمایش میگذارد.